Това ръководство ще илюстрира процеса на използване на графиката на знания за разговор в LangChain.

Как да използвам Conversation Knowledge Graph в LangChain?

The РазговорKGПамет библиотека може да се използва за пресъздаване на паметта, която може да се използва за получаване на контекста на взаимодействието. За да научите процеса на използване на графиката на знания за разговор в LangChain, просто преминете през изброените стъпки:

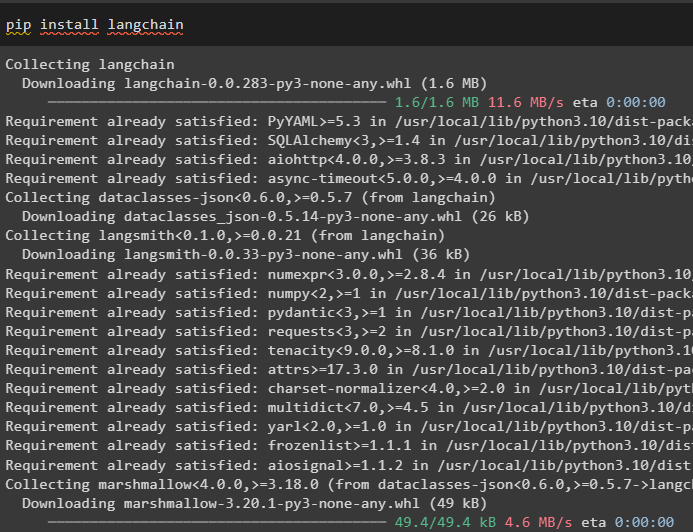

Стъпка 1: Инсталирайте модули

Първо, започнете с процеса на използване на графиката на знания за разговор, като инсталирате модула LangChain:

pip инсталирайте langchain

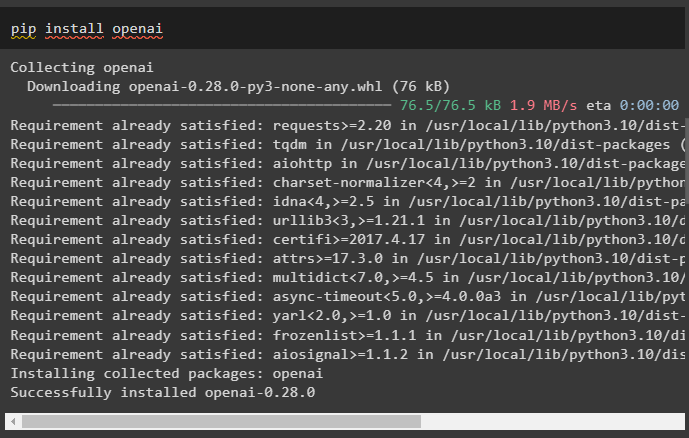

Инсталирайте модула OpenAI, който може да бъде инсталиран с помощта на командата pip, за да получите неговите библиотеки за изграждане на големи езикови модели:

pip инсталирайте openai

Сега, настройте средата използвайки ключа OpenAI API, който може да бъде генериран от неговия акаунт:

импортиране Вие

импортиране getpass

Вие . приблизително [ „OPENAI_API_KEY“ ] = getpass . getpass ( „API ключ на OpenAI:“ )

Стъпка 2: Използване на памет с LLM

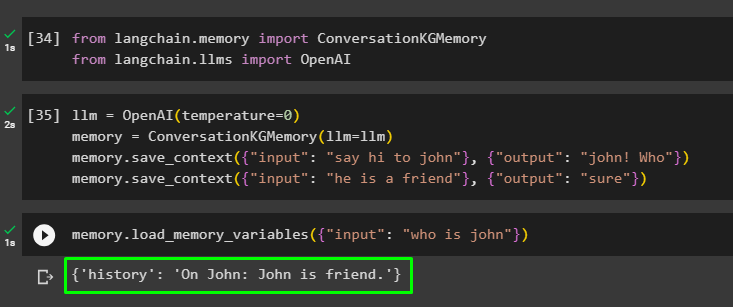

След като модулите са инсталирани, започнете да използвате паметта с LLM, като импортирате необходимите библиотеки от модула LangChain:

от Langchain. памет импортиране РазговорKGПаметот Langchain. llms импортиране OpenAI

Изградете LLM с помощта на метода OpenAI() и конфигурирайте паметта с помощта на РазговорKGПамет () метод. След това запазете шаблоните за подкана, като използвате множество входове със съответния им отговор, за да обучите модела на тези данни:

llm = OpenAI ( температура = 0 )памет = РазговорKGПамет ( llm = llm )

памет. save_context ( { 'вход' : 'кажи здрасти на Джон' } , { 'изход' : 'Джон! Кой' } )

памет. save_context ( { 'вход' : 'той е приятел' } , { 'изход' : 'сигурен' } )

Тествайте паметта, като заредите памет_променливи () метод, използващ заявката, свързана с горните данни:

памет. load_memory_variables ( { 'вход' : 'кой е Джон' } )

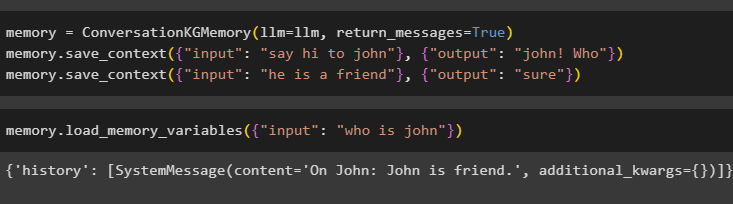

Конфигурирайте паметта с помощта на метода ConversationKGMemory() с върнати_съобщения аргумент, за да получите и историята на входа:

памет = РазговорKGПамет ( llm = llm , върнати_съобщения = Вярно )памет. save_context ( { 'вход' : 'кажи здрасти на Джон' } , { 'изход' : 'Джон! Кой' } )

памет. save_context ( { 'вход' : 'той е приятел' } , { 'изход' : 'сигурен' } )

Просто тествайте паметта, като предоставите входния аргумент с неговата стойност под формата на заявка:

памет. load_memory_variables ( { 'вход' : 'кой е Джон' } )

Сега тествайте паметта, като зададете въпроса, който не е споменат в данните за обучението и моделът няма представа за отговора:

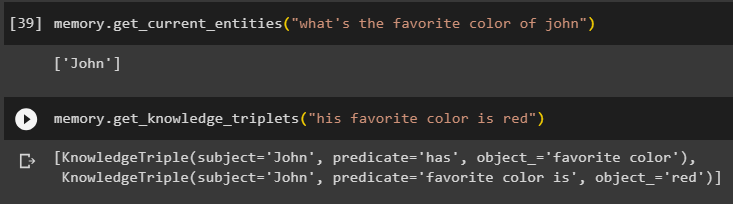

памет. get_current_entities ( 'кой е любимият цвят на Джон' )Използвай get_knowledge_triplets () чрез отговор на запитването, зададено по-рано:

памет. get_knowledge_triplets ( 'любимият му цвят е червен' )

Стъпка 3: Използване на памет във верига

Следващата стъпка използва паметта за разговор с веригите, за да изгради LLM модела с помощта на метода OpenAI(). След това конфигурирайте шаблона за подкана, като използвате структурата на разговора и текстът ще бъде показан, докато получавате изхода от модела:

llm = OpenAI ( температура = 0 )от Langchain. подкани . подкана импортиране PromptTemplate

от Langchain. вериги импортиране ConversationChain

шаблон = '''Това е шаблонът за взаимодействие между човек и машина

Системата е AI модел, който може да говори или извлича информация за множество аспекти

Ако не разбира въпроса или не знае отговора, той просто го казва

Системата извлича данни, съхранени в секцията „Конкретни“ и не халюцинира

Конкретен:

{история}

Разговор:

Човек: {вход}

AI:'''

#Конфигурирайте шаблона или структурата за предоставяне на подкани и получаване на отговор от AI системата

подкана = PromptTemplate ( входни_променливи = [ 'история' , 'вход' ] , шаблон = шаблон )

разговор_с_кг = ConversationChain (

llm = llm , многословен = Вярно , подкана = подкана , памет = РазговорKGПамет ( llm = llm )

)

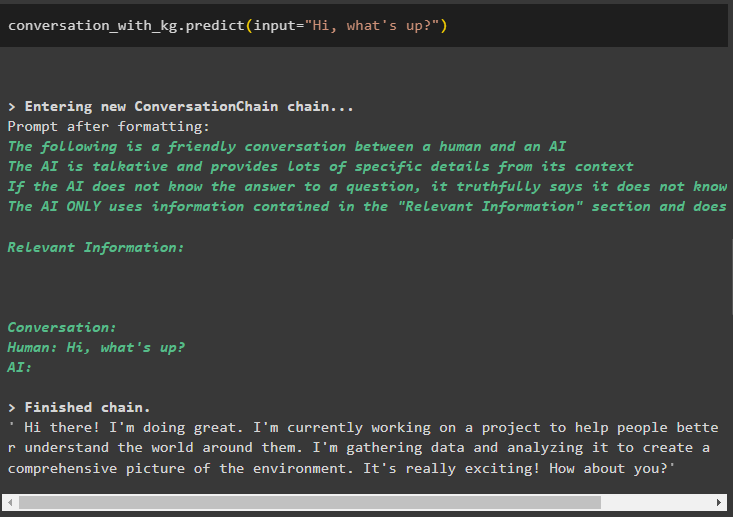

След като моделът е създаден, просто извикайте разговор_с_кг модел с помощта на метода predict() със заявката, зададена от потребителя:

разговор_с_кг. прогнозирам ( вход = 'Здрасти какво става?' )

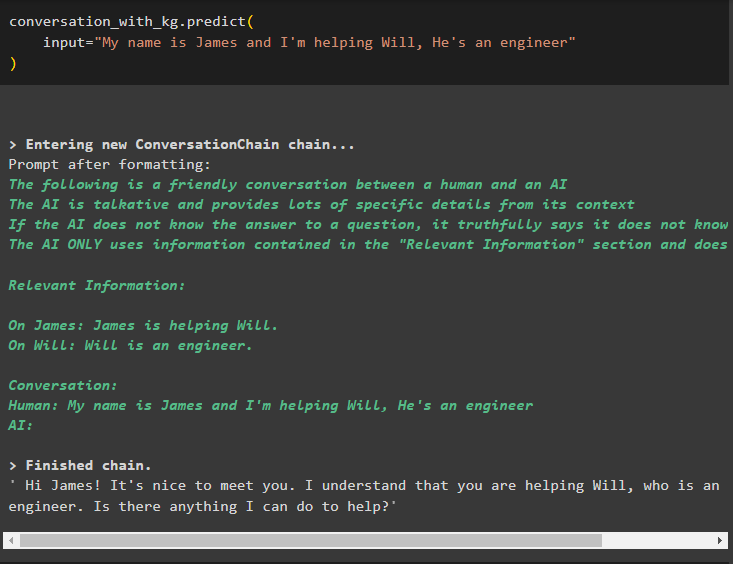

Сега обучете модела, като използвате паметта за разговори, като дадете информацията като входен аргумент за метода:

разговор_с_кг. прогнозирам (вход = „Казвам се Джеймс и помагам на Уил, той е инженер“

)

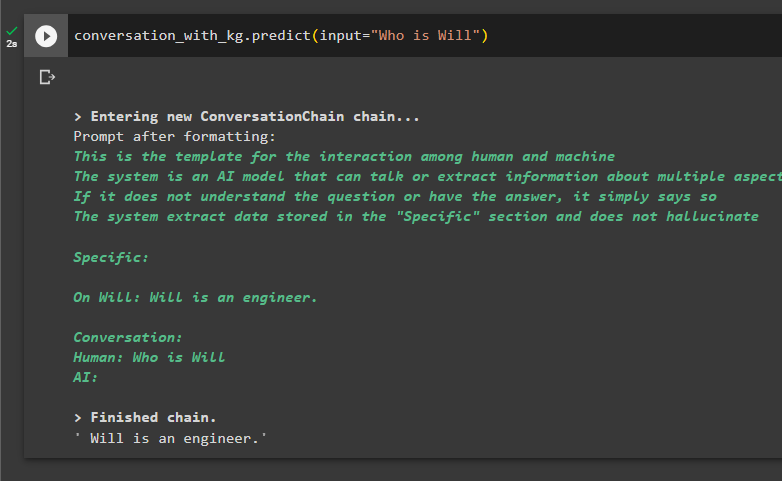

Тук е моментът да тествате модела, като поискате от заявките да извлекат информация от данните:

разговор_с_кг. прогнозирам ( вход = 'Кой е Уил' )

Това е всичко за използването на графиката на знания за разговор в LangChain.

Заключение

За да използвате графиката на знания за разговор в LangChain, инсталирайте модулите или рамките за импортиране на библиотеки за използване на метода ConversationKGMemory(). След това изградете модела, като използвате паметта, за да изградите веригите и да извлечете информация от данните за обучение, предоставени в конфигурацията. Това ръководство разработи подробно процеса на използване на графиката на знания за разговор в LangChain.