Това ръководство ще илюстрира процеса на стартиране на LLMChains в LangChain.

Как да стартирате LLMChains в LangChain?

LangChain предоставя функциите или зависимостите за изграждане на LLMChains с помощта на LLM/Chatbots и шаблони за подкани. За да научите процеса на изграждане и стартиране на LLMChains в LangChain, просто следвайте следното поетапно ръководство:

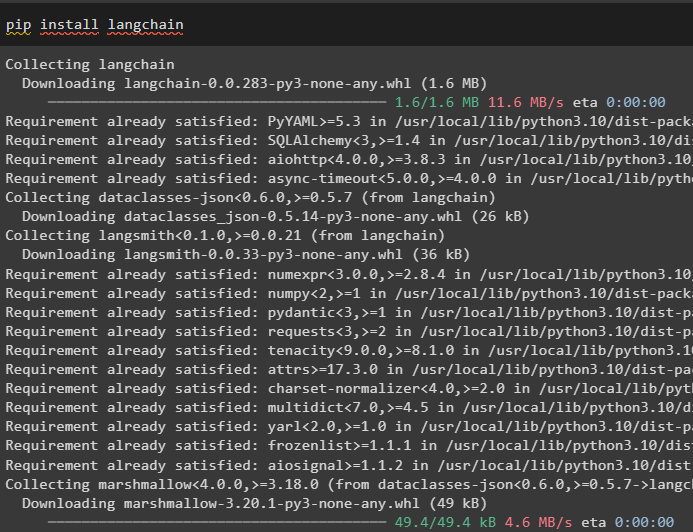

Стъпка 1: Инсталирайте пакети

Първо, започнете с процеса, като инсталирате модула LangChain, за да получите неговите зависимости за изграждане и стартиране на LLMChains:

pip инсталирайте langchain

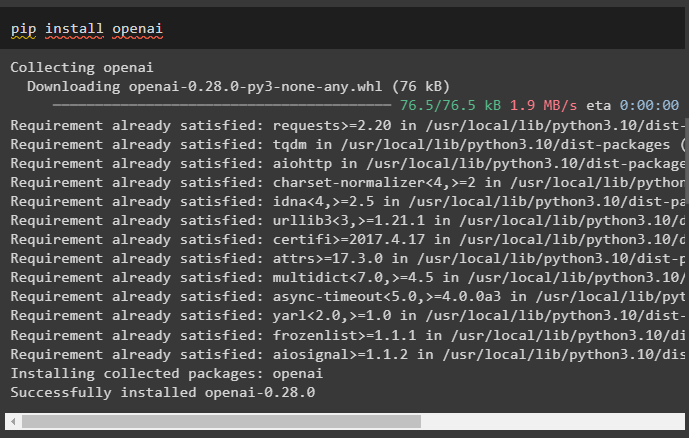

Инсталирайте рамката OpenAI с помощта на командата pip, за да накарате библиотеките да използват функцията OpenAI() за изграждане на LLM:

pip инсталирайте openai

След инсталирането на модулите, просто настройте средата променливи с помощта на API ключа от OpenAI акаунта:

импортиране Вие

импортиране getpass

Вие . приблизително [ „OPENAI_API_KEY“ ] = getpass . getpass ( „API ключ на OpenAI:“ )

Стъпка 2: Импортирайте библиотеки

След като настройката приключи и всички необходими пакети са инсталирани, импортирайте необходимите библиотеки за изграждане на шаблона за подкана. След това просто изградете LLM с помощта на метода OpenAI() и конфигурирайте LLMChain с помощта на LLM и шаблона за подкана:

от Langchain импортиране PromptTemplateот Langchain импортиране OpenAI

от Langchain импортиране LLMChain

prompt_template = 'дайте ми добро заглавие за бизнес, който прави {product}?'

llm = OpenAI ( температура = 0 )

llm_chain = LLMChain (

llm = llm ,

подкана = PromptTemplate. от_шаблон ( prompt_template )

)

llm_chain ( 'цветни дрехи' )

Стъпка 3: Пускане на вериги

Вземете входния списък, съдържащ различни продукти, произведени от бизнеса, и стартирайте веригата, за да покажете списъка на екрана:

input_list = [{ 'продукт' : 'чорапи' } ,

{ 'продукт' : 'компютър' } ,

{ 'продукт' : 'обувки' }

]

llm_chain. Приложи ( input_list )

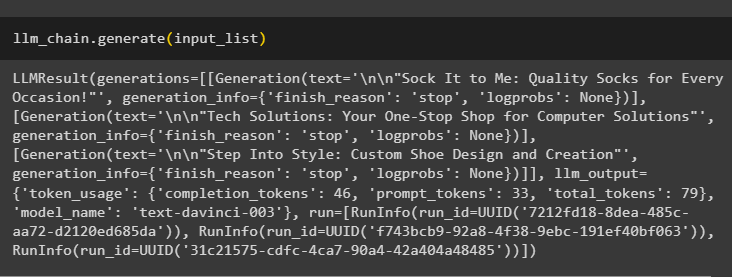

Стартирайте метода generate(), като използвате input_list с LLMChains, за да получите изхода, свързан с разговора, генериран от модела:

llm_chain. генерирам ( input_list )

Стъпка 4: Използване на единичен вход

Добавете друг продукт, за да стартирате LLMChains, като използвате само един вход и след това предскажете, че LLMChain ще генерира изхода:

llm_chain. прогнозирам ( продукт = 'цветни чорапи' )Стъпка 5: Използване на множество входове

Сега изградете шаблона за използване на множество входове за предоставяне на командата към модела, преди да стартирате веригата:

шаблон = '''Разкажи ми {adjective} виц за {subject}.'''подкана = PromptTemplate ( шаблон = шаблон , входни_променливи = [ 'прилагателно' , 'предмет' ] )

llm_chain = LLMChain ( подкана = подкана , llm = OpenAI ( температура = 0 ) )

llm_chain. прогнозирам ( прилагателно = 'тъжен' , предмет = 'патици' )

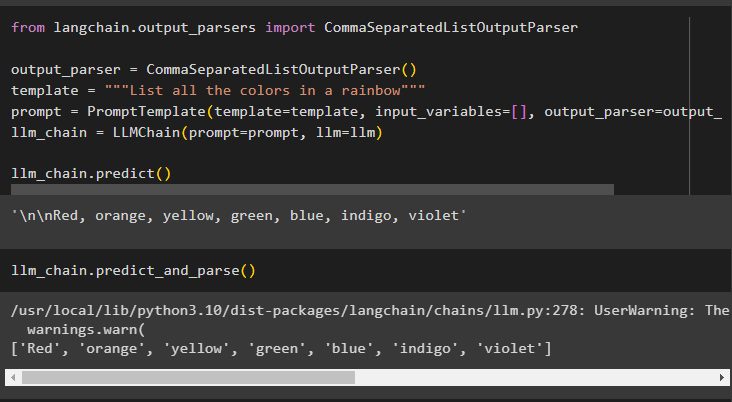

Стъпка 6: Използване на изходен анализатор

Тази стъпка използва метода на изходния анализатор, за да стартира LLMChain, за да получи изхода въз основа на подканата:

от Langchain. изходни анализатори импортиране CommaSeparatedListOutputParserизходен_парсер = CommaSeparatedListOutputParser ( )

шаблон = '''Избройте всички цветове в дъга'''

подкана = PromptTemplate ( шаблон = шаблон , входни_променливи = [ ] , изходен_парсер = изходен_парсер )

llm_chain = LLMChain ( подкана = подкана , llm = llm )

llm_chain. прогнозирам ( )

Използването на метода parse() за получаване на изхода ще генерира разделен със запетаи списък на всички цветове в дъгата:

llm_chain. прогнозиране_и_разбор ( )

Стъпка 7: Инициализиране от низове

Тази стъпка обяснява процеса на използване на низ като подкана за стартиране на LLMChain с помощта на LLM модел и шаблон:

шаблон = '''Разкажи ми {adjective} виц за {subject}'''llm_chain = LLMChain. от_низ ( llm = llm , шаблон = шаблон )

Осигурете стойностите на променливите в подканата за низ, за да получите изхода от модела, като стартирате LLMChain:

llm_chain. прогнозирам ( прилагателно = 'тъжен' , предмет = 'патици' )Това е всичко за пускането на LLMChains с помощта на рамката LangChain.

Заключение

За да създадете и стартирате LLMChains в LangChain, инсталирайте предпоставките като пакети и настройте средата с помощта на API ключа на OpenAI. След това импортирайте необходимите библиотеки за конфигуриране на шаблона за подкана и модела за изпълнение на LLMChain с помощта на зависимостите на LangChain. Потребителят може да използва изходни анализатори и низови команди, за да стартира LLMChains, както е показано в ръководството. Това ръководство разработи подробно целия процес на стартиране на LLMChains в LangChain.