В този блог ще се съсредоточим върху начините, по които можете да увеличите използването на GPU в PyTorch.

Как да увеличите използването на GPU в PyTorch?

Има няколко техники, които могат да бъдат използвани за увеличаване на използването на GPU и гарантиране, че се използват най-добрите хардуерни ресурси за обработката на сложни модели за машинно обучение. Тези тактики включват редактиране на кода и използване на функциите на PyTorch. Някои важни съвети и трикове са изброени по-долу:

- Зареждане на данни и размери на партиди

- По-малко зависими от паметта модели

- PyTorch Lightning

- Коригирайте настройките за изпълнение в Google Colab

- Изчистване на кеша за оптимизация

Зареждане на данни и размери на партиди

„ Устройство за зареждане на данни ” в PyTorch се използва за определяне на спецификациите на данните, които да бъдат заредени в процесора с всяко преминаване напред на модела за дълбоко обучение. По-голямо „ размер на партидата ” данни ще изисква повече процесорна мощност и ще увеличи използването на наличния GPU.

Синтаксисът за присвояване на Dataloader със специфичен партиден размер в PyTorch към потребителска променлива е даден по-долу:

Increase_GPU_Utilization = DataLoader ( партиден_размер = 32 )

По-малко зависими от паметта модели

Всяка моделна архитектура изисква различен обем на „ памет ”, за да работи на оптималното си ниво. Моделите, които са ефективни при използване на по-малко памет за единица време, могат да работят с размери на партиди, които са много по-големи от тези на другите.

PyTorch Lightning

PyTorch има намалена версия, която е „ PyTorch Lightning ”. Той е оптимизиран за светкавична производителност, както се вижда от името му. Lightning използва GPU по подразбиране и предлага много по-бърза обработка за модели на машинно обучение. Основно предимство на Lightning е липсата на изискване за шаблонен код, който може да затрудни обработката.

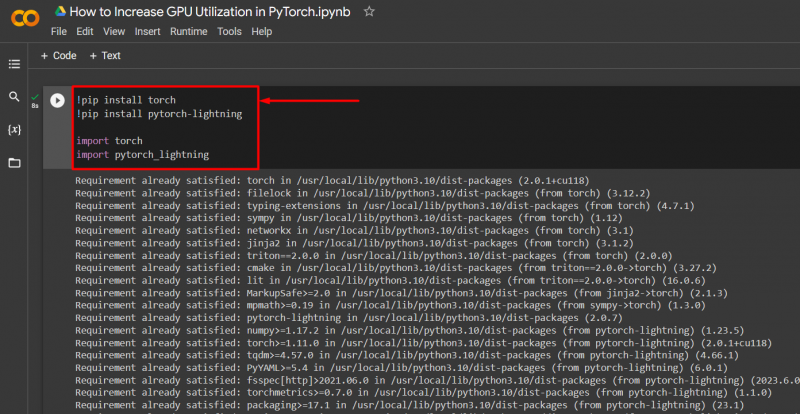

Импортирайте необходимите библиотеки в проект на PyTorch със синтаксиса, даден по-долу:

! горелка за инсталиране на pip

! pip инсталирайте pytorch - мълния

импортиране факла

импортиране pytorch_lightning

Коригирайте настройките за изпълнение в Google Colab

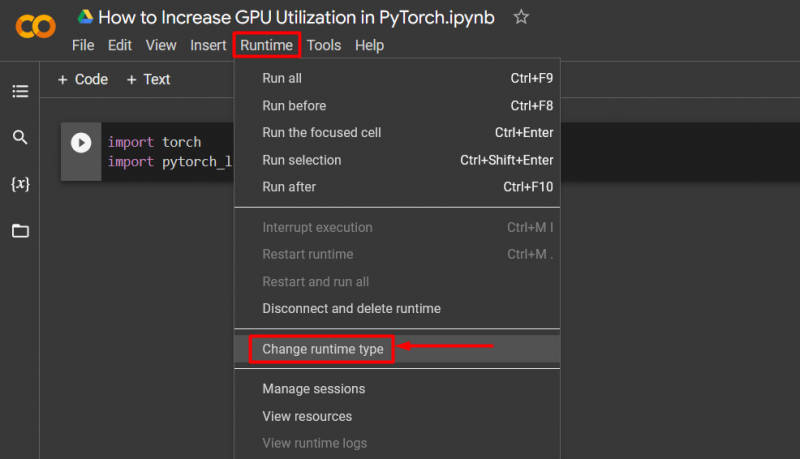

Google Colaboratory е облачна IDE, която предоставя безплатен достъп до GPU на своите потребители за разработване на модели на PyTorch. По подразбиране проектите на Colab се изпълняват на CPU, но настройките могат да се променят.

Отворете бележника на Colab, отидете на „ Време за изпълнение ” в лентата с менюта и превъртете надолу до „ Промяна на настройките за изпълнение ”:

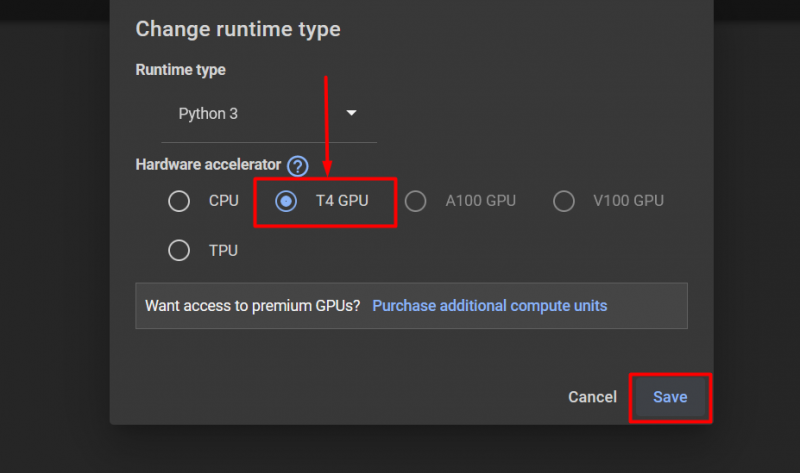

След това изберете 'T4 GPU' опция и щракнете върху „ Запазване ”, за да приложите промените за използване на GPU:

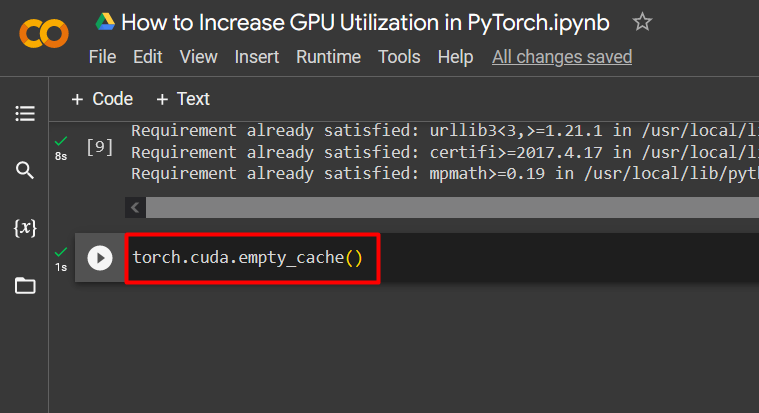

Изчистване на кеша за оптимизация

PyTorch позволява на своите потребители да изчистят кеша на паметта, за да могат да освободят място за стартиране на нови процеси. „ Кеш памет ” съхранява данни и информация за моделите, които се изпълняват, така че да може да спести време, което ще бъде изразходвано за презареждане на тези модели. Изчистването на кеша предоставя на потребителите повече място за стартиране на нови модели.

Командата за изчистване на кеша на GPU е дадена по-долу:

факла. различен . празен_кеш ( )

Тези съвети се използват за оптимизиране на работата на модели за машинно обучение с GPU в PyTorch.

Професионален съвет

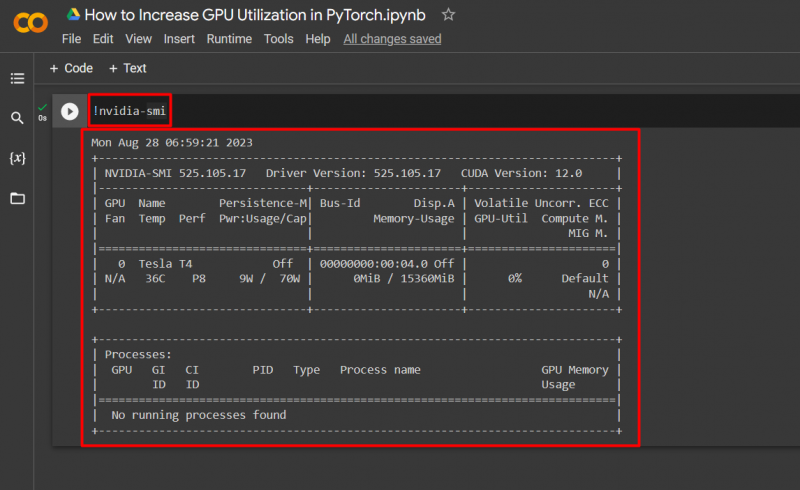

Google Colab позволява на своите потребители достъп до подробности за използването на GPU чрез „ nvidia ”, за да получите информация къде се използват хардуерните ресурси. Командата за показване на подробности за използването на GPU е дадена по-долу:

! nvidia - smi

Успех! Току-що демонстрирахме няколко начина за увеличаване на използването на GPU в PyTorch.

Заключение

Увеличете използването на GPU в PyTorch чрез изтриване на кеша, използване на PyTorch Lightning, коригиране на настройките за време на изпълнение, използване на ефективни модели и оптимални размери на партиди. Тези техники до голяма степен гарантират, че моделите за задълбочено обучение работят по най-добрия начин и могат да направят валидни заключения и изводи от наличните данни. Ние демонстрирахме техниките за увеличаване на използването на GPU.