Тази публикация ще илюстрира процеса на изграждане на LangChain приложения с помощта на Prompt Template и Output Parser.

Как да създавам LangChain приложения с помощта на подканващ шаблон и изходен парсер?

За да изградите приложението LangChain, като използвате шаблона за подкана и изходния анализатор, просто преминете през това лесно ръководство:

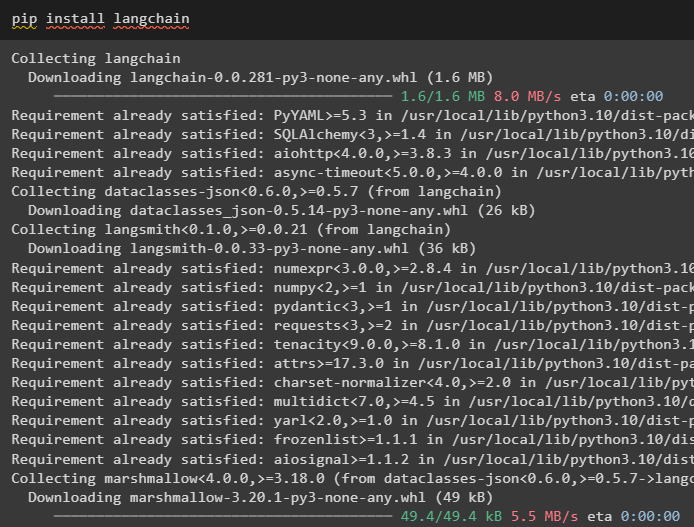

Стъпка 1: Инсталирайте LangChain

Първо, стартирайте процеса на изграждане на приложения на LangChain, като инсталирате рамката на LangChain, като използвате „ пип ” команда:

pip инсталирайте langchain

Стъпка 2: Използване на шаблон за подкана

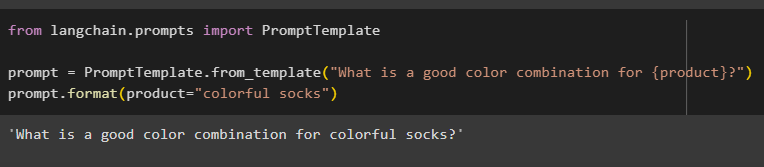

След като инсталирате модулите LangChain, импортирайте „ PromptTemplate ” библиотека за изграждане на шаблон за подкана чрез предоставяне на заявка за модела, за да разбере въпроса:

от langchain.prompts импортирайте PromptTemplate

prompt = PromptTemplate.from_template('Каква е добра цветова комбинация за {продукт}?')

prompt.format(product='цветни чорапи')

Резултатът автоматично комбинира изречението със стойността на „ продукт ” променлива:

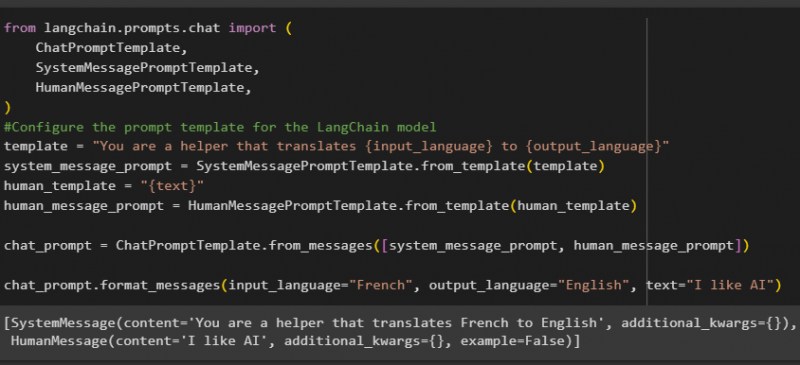

След това изградете друг шаблон за подкана, като импортирате библиотеките HumanMessagePromptTemplate, ChatPromptTemplate и SystemMessagePromptTemplate от LangChain:

от импортиране на langchain.prompts.chat (ChatPromptTemplate,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

#Конфигурирайте шаблона за подкана за модела LangChain

template = 'Вие сте помощник, който превежда {input_language} на {output_language}'

system_message_prompt = SystemMessagePromptTemplate.from_template(шаблон)

human_template = '{текст}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_language='френски', output_language='английски', text='харесвам AI')

След като импортирате всички необходими библиотеки, просто създайте персонализирания шаблон за заявките, като използвате променливата на шаблона:

Шаблоните за подкана се използват само за задаване на шаблона за заявката/въпроса и той не отговаря с никакъв отговор на въпроса. Функцията OutputParser() обаче може да извлича отговори, както се обяснява в следващия раздел с примера:

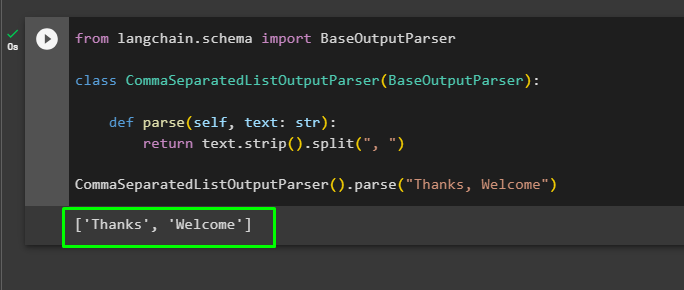

Стъпка 3: Използване на изходен анализатор

Сега импортирайте библиотеката BaseOutputParser от LangChain, за да разделите текстовите стойности, разделени със запетаи, и да върнете списъка в изхода:

от langchain.schema импортирайте BaseOutputParserклас CommaSeparatedListOutputParser(BaseOutputParser):

def parse(self, text: str):

върне text.strip().split(', ')

CommaSeparatedListOutputParser().parse('Благодаря, Добре дошли')

Това е всичко за изграждането на приложението LangChain с помощта на шаблона за подкана и анализатора на изхода.

Заключение

За да създадете приложение LangChain, като използвате шаблона за подкана и изходния анализатор, просто инсталирайте LangChain и импортирайте библиотеки от него. Библиотеката PromptTemplate се използва за изграждане на структурата за заявката, така че моделът да може да разбере въпроса, преди да извлече информация с помощта на функцията Parser(). Функцията OutputParser() се използва за извличане на отговори въз основа на заявките, персонализирани преди това. Това ръководство обяснява процеса на изграждане на LangChain приложения с помощта на шаблона за подкана и анализатора на изхода.